华南理工大学金连文教授团队在CVPR16 VIVA竞赛中获得多项第一

文章来源: | 发布时间:2016-10-20 | 【打印】 【关闭】

在国家重点研发计划“云端融合的自然交互设备和工具”的支持下,在刚刚结束的2016年CVPR会议的VIVA(智能驾驶及应用)手部检测及分类挑战赛中,本项目课题5华南理工大学金连文教授团队在手部检测和手部分类两项任务中取得多项技术指标第一名。

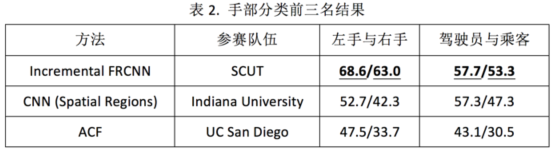

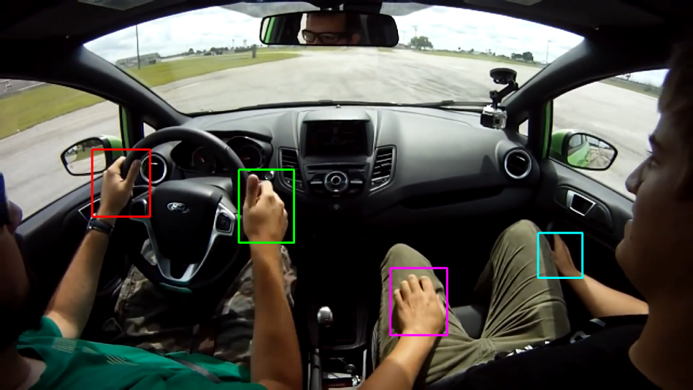

VIVA是基于视觉系统的智能驾驶及应用的挑战赛,今年是第二届比赛。VIVA手部竞赛有两个任务,一个是从驾驶室中拍摄的彩色图像中检测出手部位置,另一个是对手部进行分类,识别出驾驶员和乘客手,以及左手和右手。这些图像在驾驶员实际驾驶的过程中拍摄,摄像头放置在驾驶员的肩膀后面或者驾驶室仪表盘位置,具体拍摄角度差异较大。图像库包含比较大的光照、角度、姿态、手部肤色和遮挡等变化和因素影响,尤其是不同视角左右手的识别,具有相当的挑战性。今年的比赛吸引了包括卡耐基梅隆大学(CMU),普渡大学 (Purdue University),加州大学圣地亚哥分校 (UC San Diego),印第安纳大学(Indiana University) 和华南理工大学(South China University of Technology, SCUT)等多个知名高校参加。

图1. CVPR HANDS detection Challenge 2016 获奖证书及华南理工大学研究生黄毅超上台领奖

图2. VIVA Challenge 手部检测及分类任务 (from http://cvrr.ucsd.edu/vivachallenge/index.php/hands)

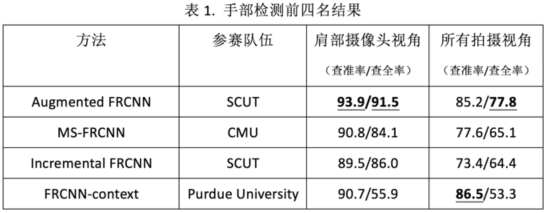

针对手部检测问题,华南理工大学团队提出了Augmented Faster R-CNN,在多次训练过程中采用随机组合训练数据,随机丢弃训练数据标记的策略,以达到正则化和减少过拟合的效果。在肩部摄像头视角数据库中,取得93.5%/91.5% (查准率/查全率),分别比第二名(来自CMU)高3.1及7.4;在所有拍摄视角数据库中,取得85.2%/77.8%的结果。上述四项指标中有三项指标获得第一。

针对手部分类问题,华南理工大学团队提出了Incremental Faster R-CNN算法,利用间隔未标注数据与标注数据一起进行半监督增强学习,在左手与右手分类任务中识别率为68.6%和63.0%,分别比第二名(来自Indiana University)高15.9和20.7;在驾驶员和乘客手部分类任务中识别率为57.7%和53.3%。上述四项指标均位列第一。