软件所在大模型少样本域适应方面取得进展

文章来源: | 发布时间:2024-04-11 | 【打印】 【关闭】

近日,中国科学院软件研究所天基综合信息系统全国重点实验室研究团队的论文BayesPrompt: Prompting Large-Scale Pre-Trained Language Models on Few-shot Inference via Debiased Domain Abstraction被机器学习领域顶级学术会议ICLR 2024接收。共同第一作者为特别研究助理李江梦、博士生宋飞。该论文提出了一种新颖的提示学习方法BayesPrompt,该方法通过探索以去偏方式近似下游任务的完整训练域,然后域抽象生成判别性提示,为预训练语言模型提供去歧义指导。

提示学习范式长期存在的问题之一是下游域的训练样本中仅包含有限且离散的语义信息,无法较好地支持传统可训练提示获得足够监督,使得生成的提示对预训练语言模型的指导变得微乎其微。这个问题导致了预训练语言模型在下游域,尤其在少样本场景下性能的下降。为此,研究团队从分布视角重新审视了预训练语言模型下游推理的原理,认为训练样本的有限会使得可训练提示只学习到目标域的有偏分布,而有偏分布仅包含部分信息且与目标域的实际分布不一致,这会引起协变量偏移问题,从而导致预训练语言模型产生知识歧义。

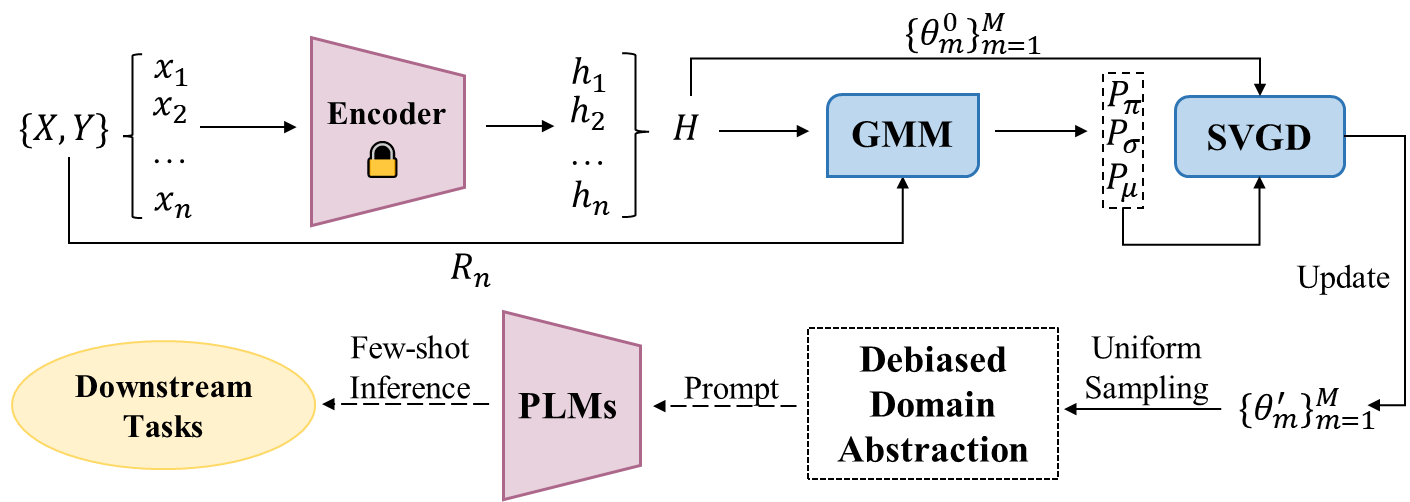

为此,研究团队提出了一种提示学习方法BayesPrompt。该方法旨在进行去偏域抽象,利用已知分布来近似下游域的去偏真实分布,再从近似分布中均匀采样代表性特征以生成对预训练语言模型(PLMs)的提示。研究团队通过贝叶斯推断算法——Stein变分梯度下降(SVGD)来实现分布近似,采用高斯混合模型(GMM)来拟合样本分布,利用所得到的分布和样本表示来初始化SVGD算法的目标分布和粒子,通过SVGD迭代更新得到一组近似于目标分布的新粒子集。通过在新粒子集中采样获得包含域判别信息的提示,来达到减轻域无关知识干扰的目的。

BayesPrompt模型框架图

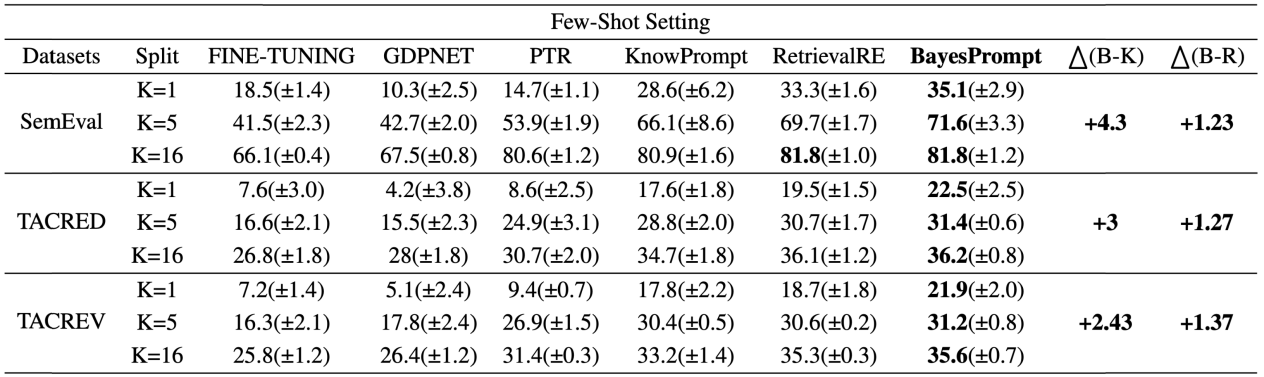

研究团队通过进一步的理论验证,证明了与基准方法相比,BayesPrompt在预训练语言模型的下游推理上获得了更紧致的分类误差上界。此外,在少样本数据集设置下的实验结果进一步证明了BayesPrompt的有效性。

少样本数据集设置下的实验结果